Одной из главных целей в генерации видео с помощью искусственного интеллекта является создание полностью управляемого, а также достоверного движения объектов. С помощью изменения сцен и улучшения качества по заданным критериям на основе предпочтений пользователя генерация контента выходит на совершенно новый уровень. К нему сделала шаг команда ByteDance Research, представив Boximator (box + animator) – новый инструмент для работы с видео на основе ИИ. ByteDance – родитель небезызвестного Tik-Tok, а из этого следует, что в скором времени там следует ожидать больше искусственно генерируемого контента. По-настоящему танцующих девушек или реального липсинка, судя по всему, станет значительно меньше :)

В этой статье вы познакомитесь с новой разработкой, узнаете о её новаторстве, архитектуре и функциях, а также о её преимуществах перед конкурентами.

Лирика

В мире исследований в области ИИ модели генерации видео занимают центральное место, представляя собой естественное развитие архитектуры U-Net моделей изображений. Они включают в себя временные слои, что обеспечивает повышение вычислительной эффективности, а также подавление шума. Однако особое внимание привлекают модели преобразования текста-в-видео (T2V), которые становятся основополагающими компонентами для различных приложений условной генерации. Тенденции в разработке T2V указывают на двухэтапный подход, включающий синтез изображения на основе текста, а затем создание видео с учетом текста и предварительно сгенерированного изображения. Это позволяет моделям сосредотачиваться на динамических аспектах, используя статическое изображение в качестве референса, что приводит к улучшению качества видео. Однако с увеличением исследований в этой области возникают вызовы, связанные с управляемостью моделей T2V и изображения-в-видео (I2V).

Исследования в основном сосредотачиваются на улучшении управляемости моделей T2V и I2V, включая разработку инновационных методов, таких как видеокомпозитор, который позволяет создавать эскизы, карты глубины и векторы движения. Однако эти подходы сталкиваются с трудностями в точном определении объектов, влияя на выбор и управление объектами на изображениях. В ответ на эти вызовы два параллельных исследования изучают использование рамок для управления движением: TrailBlazer и FACTOR, но Boximator представляет новый уровень контроля в обучении моделей T2V и I2V.

Что за зверь?

Говоря про генерацию видео, на ум приходят Pika и Gen-2 от Runway, но Boximator не только даёт более качественный результат, но на порядок функциональнее. Обученный на базе PixelDance и ModelScope, он позволяет определять последовательность перемещений в видео с помощью простых рисунков четырёхугольников hard box (исключительно объект) и soft box (более широкую область), не используя текстовый промпт.

Каждая рамка кодируется четырьмя координатами, а объекту как на фоне, так и на переднем плане, присваивается свой идентификатор, благодаря чему они могут взаимодействовать. Кроме того, пунктирной рамкой и стрелкой направления можно обозначить приблизительное или точное перемещение объектов, а также их форму. В случае, если пользователь не выделил какие-либо объекты, то Boximator по своему усмотрению обозначит их вместе с дальнейшей траекторией движения.

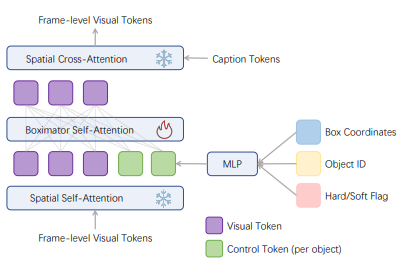

![Здесь bloc - 4D-вектор, содержащий координаты верхнего левого и нижнего правого углов коробки, нормализованный в диапазоне [0,1]. Идентификатор объекта, bid, выражается в цветовом пространстве RGB и используется для связывания коробок между кадрами. Каждый объект имеет уникальный "цвет" для своих коробок, представляя bid как 3D-вектор, нормализованный в [0,1]. Параметр bflag - логический индикатор (1 для жестких коробок, 0 в противном случае). Эти три входа обрабатываются с использованием преобразования Фурье и многослойного персептрона (MLP). Здесь bloc - 4D-вектор, содержащий координаты верхнего левого и нижнего правого углов коробки, нормализованный в диапазоне [0,1]. Идентификатор объекта, bid, выражается в цветовом пространстве RGB и используется для связывания коробок между кадрами. Каждый объект имеет уникальный "цвет" для своих коробок, представляя bid как 3D-вектор, нормализованный в [0,1]. Параметр bflag - логический индикатор (1 для жестких коробок, 0 в противном случае). Эти три входа обрабатываются с использованием преобразования Фурье и многослойного персептрона (MLP).](https://habrastorage.org/getpro/habr/upload_files/44e/efe/94c/44eefe94c8293a4461528d1fab8f56aa.png)

Boximator основан на передовых моделях видеораспределения с использованием архитектуры 3D U-Net, который структурирован со сменяющимися блоками свертки и блоками внимания. Каждый блок состоит из пространственной части, ответственной за управлением отдельными кадрами, и временной части, благодаря которой осуществляется обмен информации между кадрами. Здесь используются итеративные процессы для прогнозирования векторов шума в зашумленных видеовходах. Они постепенно улучшают чистый гауссовский шум до видеокадров высокого качества. U-Net, обозначенный как ϵθ, работает с зашумленным входом z, будь то в пространстве пикселей или латентном пространстве, вместе с меткой времени t и различными условиями. Его задача - предсказать шум внутри z через функцию потерь предсказания шума:

Кроме того, Boximator может выступать и в качестве подключаемого модуля: оставляя наработки первичной модели, он, не затрагивая исходники, обучает её с помощью заморозки текстового кодировщика базовой модели и U-Net, передавая кодировку через новый тип слоя самообучения. Беря за референс GLIGEN, где рамки объединяются с текстом описания объекта для управления областью синтеза изображений, Boximator не полагается на текст, а изучает взаимодействие между рамкой и объектом исключительно на основе визуальных данных.

Самообучение и самонаблюдение

Из-за отсутствия доступной коллекции видео с аннотациями был создан специальный тренировочный набор на основе WebVid-10M. На большинстве роликов не было значительных движений объектов или камеры, в связи с чем выборка сократилась. С конечным материалом работали так: сначала каждый ролик оценивали в наборе данных, сравнивали первый и последний кадр, и оставляли только те клипы, где различия были достаточно заметными. Осталось чуть больше миллиона видео. Первый кадр использовался для создания описания изображения, после чего существительные из текста были взяты как подсказки для объекта, которые в свою очередь передавались в уже обученную модель и трекер объектов. Благодаря этому на всех видео появились рамки, в общей сложности очертившие более 2,4 млн объектов.

Тренировка заключалась в использовании случайного видео с определенным соотношением сторон. Видео обрезалось, и на его пространство и проецировались рамки. В случае, если рамка выходила за пределы обрезанной области, она проецировалась в виде пунктира вдоль границы обрезки. Как итог – стало возможным контролирование движения объектов как внутри, так и вне кадра посредством обозначения линейного пунктира на его границе.

Обучение проходило в несколько этапов. На предварительной фазе модель распознает любые рамки как hard box, устанавливается понимание координат и идентификаторов. Далее 80% этих рамок заменяются на soft box, которые генерируются случайным образом, увеличивая площадь hard box (в среднем это 1/9 ширины или высоты кадра, но максимальное расширение может достигнуть границы кадра). На всех этапах использовалась техника самонаблюдения.

Благодаря этой технике изучение взаимодействия четырёхугольников и выделяемых объектов стало значительно проще. Она обучает модель генерировать цветные ограничивающие рамки как часть видео, благодаря чему задача упрощается до двух простых шагов: создание рамки для каждого объекта нужного цвета и выравнивание этих рамок с ограничениями от Boximator в каждом кадре. Другими словами, модель обучается выполнять генерацию и отслеживание объектов одновременно. Так, самонаведенные ограничивающие рамки выступают в качестве промежуточного представления: модель следует ограничениям Boximator, направляя генерацию этих рамок, которые, в свою очередь, направляют генерацию объектов.

Самоэксперименты и саморезультаты

Модель тестировалась на трех наборах данных: MSR-VTT, ActivityNet и UCF-1011. MSR-VTT, к примеру, содержит 2990 образцов с 20 подсказками для каждого образца. Текстовые ограничения выбираются случайным образом, а для ограничений рамок автоматически генерируются ограничивающие рамки на основе текстовых подсказок.

Оценочные метрики включают Frechet Video Distance (FVD) для оценки качества видео, CLIP similarity score (CLIPSIM) для оценки совпадения текста и средний показатель точности (AP) для оценки управления движением. Метрики FVD вычисляются с использованием случайно выбранных 16 кадров каждого видео с частотой кадров 4. Управление движением оценивается с использованием AP, учитывая ограничения ограничивающих рамок на первом и последнем кадрах. Обнаружение ограничивающих рамок выполняется с использованием системы DINO+DEVA, и AP вычисляется согласно протоколу MS COCO. Также предоставляется средняя средняя точность (mAP), рассчитанная как средний AP по 10 порогам пересечения объединения (IoU) от 0,5 до 0,95.

Результаты говорят сами за себя: в наборе данных MSR-VTT Boximator улучшает базовые модели по показателю FVD, а с добавлением ограничений по рамкам качество видео значительно повышается (PixelDance: 237 → 174, ModelScope: 239 → 216).

Показатели CLIP similarity (CLIPSIM) сравнимы с системами последнего поколения, с небольшим снижением при введении дополнительных условий (например, F0 или Box). Это происходит из-за того, что базовая модель оптимизирована для выравнивания видео только с текстом, в то время как Boximator обрабатывает несколько видов выравнивания одновременно.

Показатель средней точности (AP) детектора объектов, измеряющий соответствие бокса объекту, значительно возрос (в 1,9-3,7 раза выше в MSR-VTT и в 4,4-8,9 раза выше в ActivityNet), что подчеркивает эффективность управления движением. Исследование пользователей также показало, что качество видео нашей модели и управление движением значительно превосходят базовую модель (+18% по качеству видео, +74% по управлению движением).

А что сказал человек?

Было проведено исследование пользовательских предпочтений на 100 образцах с участием четырёх людей. На каждой сессии им предоставлялись два видеоролика в случайном порядке: один, созданный базовой моделью (PixelDance) с использованием текстовой подсказки и первого кадра в качестве входных данных, и другой – с моделью Boximator, которая дополнительно использует ограничения рамок. Оценщикам предлагалось выразить свои предпочтения в отношении качества видео и управления движением.

Модель Boximator была предпочтительна с заметным отрывом. Она превосходила в управлении движением в 76% случаев, уступая базовой модели всего в 2,2% случаев. Качество видео модели Boximator также было более предпочтительным (+18,4%), вероятно, из-за динамичного и яркого контента, созданного благодаря ограничениям рамок. Это свидетельствует о том, что пользователи предпочли модель Boximator базовой модели как в плане управления движением, так и в качестве видео.

Заключение

Бесспорно, Boximator является новой вехой в синтезе видео. Избегая текст, он делает процесс генерации более управляемым. Кроме того, возможность его интеграции с другими диффузионными моделями открывает новые перспективы в производительности, а самонаблюдение упрощает процесс обучения, методы которого могут открыть новые формы управления объектами: более точные человеческие движения, например.

Наравне с этим не стоит забывать про этические риски. Развитие искусственной генерации видео пропорционально развитию дипфейков. Появляются новые вопросы, касающиеся интеллектуальной собственности.

Но то, что еноты теперь смогут качественно поиграть в мяч – несомненно, радует :)

Благодарю вас за прочтение статьи. Буду рад вашему фидбэку в комментариях!